Projekt je dopodrobna sepsaný, investice připravená, partneři informovaní – a pak se věci nepovedou tak, jak se to na začátku naplánuje. VŽDYCKY!

Dali jsme dohromady sedm konkrétních problémů, na které jsme narazili, když jsme v The Cloud Provider stavěli nový cloud, a jak jsme je vyřešili. Kdo by se nechtěl poučit z cizích chyb, třeba ho alespoň potěší cizí (ne)štěstí?

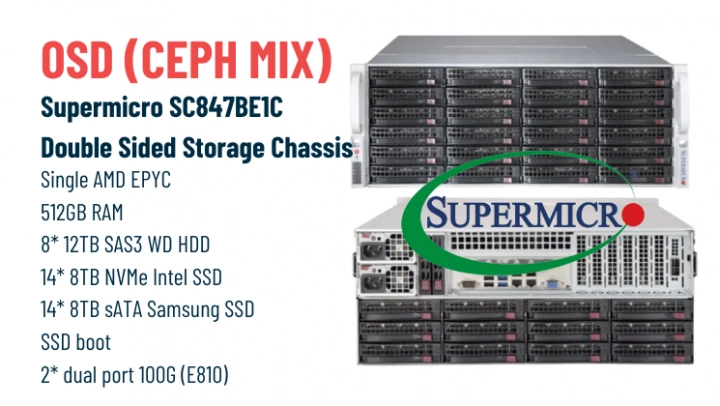

Nevyhovující architektura hardwaru pro CEPH

Než jsme začali řešit výběrové řízení na dodavatele, dali dohromady požadavky na fyzickou architekturu, mimo jiné pro systém CEPH. Jak se protahovaly termíny dodávky, technici nelenili a vylepšovali původní řešení. Vlastně ho předělali téměř úplně, ale nutno říci že k lepšímu.

Původní koncept samostatných polí, a tedy HW dle typu disků, byl přepracován na kombinované stroje se všemi typy a s mnohem lepší propustností. Na co ale při svých úpravách nemysleli, bylo zatížení PCIx linek v každém serveru. Všechny inovace nás dohnali při zahořování serverů u dodavatele, kdy se zjistilo, že je celý systém nestabilní a nedosahuje požadovaných propustností.

Náš partner, společnost Abacus Electric, s.r.o., který nám dodával servery Supermicro a další komponenty, na ten problém nejen přišel, ale také zajistil testy na různých HW konfiguracích. Výsledkem byla kompletní změna architektury z technologie dual socket Intel na single socket AMD.

Sice jsme museli překousnout pocit nelibosti vůči použití pouze jednoho procesoru, kde bychom raději viděli dva, ale AMD fungovalo. Zajistilo stabilitu a také správný výkon sběrnic. Funkční CEPH byl na světě.

Předělávání projektu za chodu

Volně navazujeme na předchozí bod, protože výběr dobrého partnera je velmi důležitý. Během stavby cloudu pro nás Abacus měl skvělé rady a návrhy, které vedly k částečnému přepracování naší architektury s ohledem na nejmodernější technologie na trhu.

Například přeskládali naše Supermicro servery tak, aby celé řešení bylo efektivnější. Také nám navrhli technické úpravy, které umožnily nabídnout technologii NVMe disků našim zákazníkům jako službu.

NVMe už není nic nového na poli IT, ale Abacus nám je pomohl využít nejen jako vnitřní cache, ale také z nich udělat NVMe disky poskytované v rámci výpočetních prostředků pro zákazníky cloudu. Skutečně se nám vyplatilo vybrat si partnera, který ví, co dělá, a umí být přizpůsobivý a upřímný.

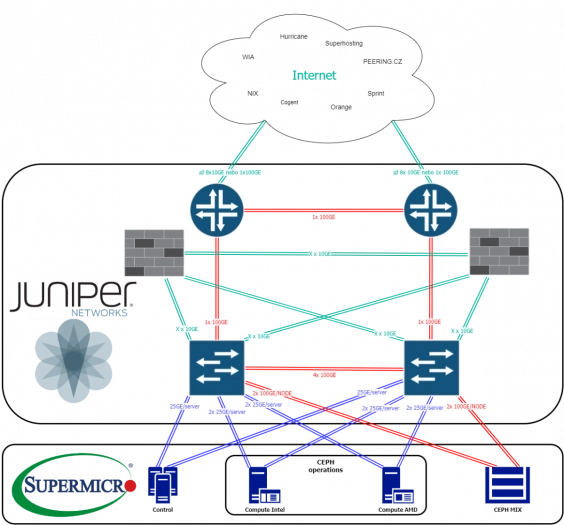

Změna přístupu k architektuře sítě

Byli jsme zvyklí používat Virtual Chassis Fabric (VCF) ke správě sítí. Ale když jsme porovnali toto řešení a EVPN-VXLAN, zjistili jsme, že stand-alone switche budou mnohem lepší řešení než řešit správu „jednoho” zařízení.

Zjistili jsme, že EVPN-VXLAN má několik nesporných výhod:

- Jakmile jeden switch škytne, ostatní stále běží a pokryjí problém.

- Díky copy/paste konfiguraci je nastavení jednotlivých switchů relativně jednoduché – jeden switch kompletně nastavíme a pak už jen přelejeme tuto konfiguraci.

- Díky paralelní architektuře je jednodušší ji škálovat.

- Protože už není řešení homogenní, nejsme omezeni vendor lock-inem.

- Stále můžete použít různé typy HW a přitom se nepřipravíte o možnost aktualizovat jednotlivé prvky za chodu a bez odstávky celého stacku

Je pravda, že jsme museli víc zamakat, aby bylo vše plně funkční, ale stálo to za to. Můžeme lépe sítě spravovat, protože máme nad každým prvkem více kontroly.

SAN

Když už jsme u sítí, musíme zmínit i způsob propojení mezi jednotlivými zařízeními navzájem a také internetem. Všechno jsme sice dopředu přesně naplánovali, ale jak jsme čekali na dodávku, technici měli roupy a vylepšovali a vylepšovali, takže nakonec jsme udělali technologicky 2 oddělené sítě. Pro komunikaci běžných serverů jsme zvolili 25Gbps propoje a pro komunikaci CEPH serverů to byly 100Gbps propoje. Obě vrstvy byly topograficky stejně udělané, jen s odlišnou propustností. A aby toho nebylo málo, tak tohle vše jsme udělali dvakrát – kvůli HA, samozřejmě.

Optika a rozplet

A sítě ještě jednou, tentokrát z fyzického pohledu. Náš výborný nápad s rozplety a předkonektorovanými kabely byla úplná katastrofa. Při rozbalení jsme zjistili, že vlastní rozplet kabelů je udělaný až půl metru před koncem kabelu. Zkuste to napojit ve dvou rozvaděčích…

Takže pokud plánujete využít rozplety, kupte kratší. Jsou levnější a lépe se vám s nimi bude pracovat s použitím optické vany. V našem případě nám krátké rozplety udělaly v kabelech takový guláš, že jsme si ani nevšimli, že jedna síťová karta je v serveru “vzhůru nohama”. Není divu, že nám to nefungovalo. Takže další velká lekce – neřešte miliardu dalších věcí, když zapojujete optické kabely s rozplety. A ještě jedna věc – nezapomeňte na ramínka 😛

Partneři

Když už jsme byli u toho chválení, tak se ale také dostaneme k oblastem, které nám pořádně zavařily. V tomto případě nejde o Abacus a ani nebudeme jmenovat. Ale vytáhneme pouze lekci, kterou jsme dostali, protože nás stála zpoždění celého projektu o několik měsíců. A to jen kvůli našemu partnerovi, nepočítáme chyby, za které jsme si mohli sami ani nepředvídané potřeby ke změně.

Během celého projektu došlo u jednoho z partnerů k výměně L2 techniků a L3 architektů. Dvakrát. Navíc náhrada za původní kompetentní zaměstnance byli lidé, kteří nebyli způsobilí řešit projekt naší velikosti a komplexnosti.

Těch několik měsíců vůbec nepřeháníme. Velkou lekcí pro nás bylo nespoléhat na smlouvu s partnerem, ale je potřeba mít “pojistku” s konkrétními osobami, aby bez ohledu na to, zda ve firmě zůstanou nebo ne, zůstali na projektu.

Zákeřné MTU

Znáte to – každé zařízení, které pořídíte, má danou defaultní velikost MTU. My jsme ale chtěli ulevit procesorům, takže jsme se pustili do toho, že velikost MTU změníme. To jsme si naběhli.

Mysleli jsme si, že jsme hodnotu parametru změnili všude, kde bylo potřeba. Pak jsme ale hodiny zjišťovali, proč místo 9 000 teče jen 1 500. Až díky velmi dobře zpracované knowledge base, která byla veřejně přístupná, se nám povedlo zjistit, kde je zakopaný pes.

Ač každá IT oblast má své odborníky, v tomhle případě bylo klíčové, že jsme začali hledat všichni – DevOps ve spolupráci s hardwarářema a síťařema. Sice mluvíme trochu jinou řečí, ale domluvit se musíme.

Závěrem

Jsme rádi, že je to všechno za námi. Teď už se můžeme relativně v klidu ohlédnout za problémy, které nastaly, ale ty měsíce, o které se projekt prodloužil, byly mírně řečeno náročné.

Snad vám naše zkušenosti pomůžou vyhnout se problémům, na kterých jsme si my málem vylámali zuby. Málem. Sami můžete vyzkoušet, jestli se vše skutečně po…

Pavel Pábl, CTO, The Cloud Provider