V tenkrát nové budově datacentra Faster v Brně jsme byli poprvé před třemi lety, kdy jsme z návštěvy připravili článek Brněnské datacentrum Faster topí teplem ze svých serverů. Už tenkrát lidé z Fasteru mluvili o svých plánech na výstavbu druhé budovy, trafostanice a nových diesel agregátů.

O tři roky později firma oslavila 25. narozeniny a při té příležitosti slavnostně druhou budovu se všemi novinkami otevřela. Byli jsme při tom a měli jsme tak možnost porovnat, jakým směrem se prostředí datacenter vyvíjí a co se změnilo za pouhé tři roky.

Podívejte se sami, jak to v novém datacentru vypadá:

Elektřina je základ

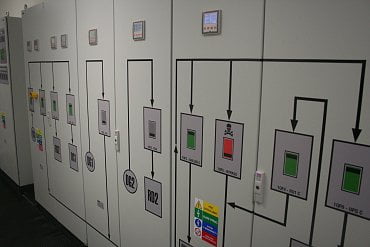

Obě budovy stojí v těsné blízkosti na jednom pozemku, jsou tedy propojené i vnitřní chodbou, která je zároveň hlavním vstupem do prostoru druhého datacentra. Provádí nás Václav Nesvadba a Zdeněk Vahala, kteří nás už v první chodbě upozorňují na řadu rozvaděčů po straně. Velkou novinkou pro nás je připojení ze dvou trafostanic. Jedna je na našem pozemku a druhá o kousek dál. Ta je sdílená, ale devadesát procent její kapacity využíváme my,

říká na úvod Nesvadba a dodává, že každá trafostanice má kapacitu 1000 kVA.

Na všech skříních s rozvaděči jsou nakreslená schémata toho, co je uvnitř. Proporce jsou přitom zachovány, takže obrázek tvoří jakousi mapu toho, co je za ním. Když jsem to dřív někde viděl, tak jsem si říkal, že je to sice hezké, ale zbytečné. Ale když řešíte nějaký problém, tak se to neskutečně hodí. Když dojde k výpadku, jde vám o každou sekundu a s tímhle nemusíte zbytečně hledat,

vysvětluje Nesvadba.

Procházíme ke dveřím ven a dostáváme se na malý dvorek za budovou, kde jsme už stáli minule. Stál tu tehdy jen jeden malý diesel agregát, který je teď schovaný pod plachtou o kousek dál. Na jeho místě jsou dva větší kontejnery se dvěma agregáty. Každý z nich má 750 kVA a je schopen utáhnout celou budovu sám. V případě výpadku startují oba najednou a teprve po nějaké chvíli se jeden z nich odstaví,

říká Nesvadba. Základnu tvoří nádrž pro dvanáct hodin běhu. Pokud by jeden agregát měl méně než deset procent paliva, automaticky se nastartuje ten druhý,

vysvětluje nám Zdeněk Vahala.

Elektřina je tu striktně vedená ve dvou větvích, které jsou všude oddělené a setkávají se až u serverů v racku. Třeba chillery na střeše jsou dva, každý z nich je schopen uchladit celé datacentrum a každý má jinou větev napájení. Opravdu se to dá celé rozstřihnout na dvě funkční poloviny,

říká Nesvadba. Můžeme jednu stranu chlazení rozřezat a opravovat. Všechno ostatní bude pořád fungovat.

Chlazení a zálohování bateriemi

Přecházíme o místnost dále, kde se nachází centrum místního chlazení. Zděněk Vahala nás nejprve upozorňuje na výměníky. Jsme tu připraveni na to, aby od nás odebíral teplo nějaký partner. Zatím o tom jednáme, ale technologicky jsme připraveni.

Uvnitř budovy proudí chladicí voda, která své teplo předává glykolu proudícímu ven do chladičů.

Chladiče venku umožňují prohnat ventilátory až 150 tisíc kubíků vzduchu za hodinu, takže jeden z nich bohatě stačí na potřeby celé budovy. Aby to bylo ekologické, propojujeme je dohromady a ony pak mají vyšší účinnost,

vysvětluje Vahala.

V této části budovy jsou za přepážkou odděleny police s bateriemi, které slouží jako úložiště energie pro UPS. Vedle něj stojí samotná řídicí jednotka, která je modulární a podle potřeby se do ní dají zasouvat další střídače a tím se zvyšuje výkon celého řešení. Zatím tím napájíme jen tohle nové datacentrum, takže jsme na začátku. Do budoucna ale můžeme pohodlně škálovat,

vysvětluje Nesvadba.

Baterie jsou v tuto chvíli nakonfigurovány na výkon 400 kW, zatím se ale používá jen polovina. Zátěž jde trvale přes invertor a přepnutí na baterie je z pohledu napájených zařízení nezaznamenatelné,

říká Václav Nesvadba. Každá baterie má svá vlastní čidla, takže je možné na ní monitorovat řadu parametrů jako napětí, proud, vnitřní odpor a teplotu. Můžeme tak včas odhalit problém a jednu baterii nechat vyměnit,

dodává Vahala. V každém okruhu je 40 baterií po 12 V.

Veškerá data z rozvaděčů, chlazení i dalších čidel v budově se sbírají v jednom systému, který dovoluje jednak informace zobrazovat, ale po přihlášení také některé prvky ovládat. Abychom si nemuseli pamatovat adresy, máme tu QR kódy s odkazy na jednotlivé části našeho systému,

směje se Nesvadba a ukazuje nám na mobilu pohled na aktuální situaci.

U šesti nových sálů

Přes další dveře chráněné čtečkou procházíme do prostoru samotných sálů. Je jich tu šest, plně v provozu je zatím jen jeden. Do každé místnosti vedou dvoje dveře, jedny jsou skleněné a druhé díky mřížce prodyšné. V původním datacentru máme vysoké podlahy a studený vzduch ze sahar pouštíme spodem, tady jsme to obrátili,

vysvětluje Nesvadba.

Sahary jsou tady k vidění pod stropem v chodbě, odkud se nasává vzduch a přes radiátor se studenou vodou se žene pod strop v malém sále. Studený vzduch pak padá dolů, takže to má větší efekt než původní obrácené řešení a ještě navíc je to technologicky jednodušší,

popisuje Václav Nesvadba. Vzduch je pak nasáván samotnými servery a na druhé straně se přirozeně přetlakem dostává skrz prodyšné dveře zase na chodbu.

Opět se tu monitoruje spousta parametrů od proudu každým jističem přes teplotu v různých částech teplé a studené uličky až po měření diferenčního tlaku vzduchu mezi teplou a studenou uličkou. Stává se nám, že zákazník odnese server, ale nenainstaluje záslepku. Tím nám vznikne ‚zkrat‘ a efektivita chlazení klesá. My jsme teď schopni to velmi rychle detekovat a vyřešit,

říká Vahala.

Silové rozvody jsou v mělkém kanále pod podlahou, veškeré datové pak naopak pod stropem. Máme dva nezávislé propoje s původním sálem v prvním datacentru,

říká Nesvadba.

Monitorují se i výpadky jističů, stejně jako jejich zatížení. Musíme automatizovaně hlídat, že není některá větev zatížená na více než padesát procent.

Pokud by v takové situaci jedna větev vypadla, přenesla by se zátěž na druhou, která by v tu chvíli byla přetížená a vypadla by taky. Proto to lidem na dohledu signalizujeme žlutou barvou a oni to musí co nejdříve nějak vyřešit,

vysvětluje Vahala.

Pro případ požáru se tu jako hasivo používá směs argonu s dusíkem, což by sice samo o sobě člověka ohrozit nemělo, ale na začátku hašení přichází výrazná tlaková vlna, která řízeně vyrazí přepážku oddělující teplou a studenou uličku. Proto tu máme třicetisekundovou únikovou dobu, která se dá stisknutím modrého tlačítka prodloužit o dalších třicet sekund,

říká Vahala.

Zákazníci chtějí modularitu

V původním datacentru je jediný sál, který není rozdělený na menší části. Pokud chtěl zákazník svůj uzavřený prostor, museli jsme stavět klece. Proto jsme se tady rozhodli udělat šest oddělených malých sálů,

vysvětluje Nesvadba. Do původního prostoru se vešlo až 124 racků, do nového jich lze umístit dalších 96.

Zároveň zákazníci čím dál častěji požadují individuální řešení, které se liší například v různě řešených přívodech elektrické energie. Tady jsme schopni podle požadavků vyměnit jističe, upravit zásuvky a udělat to tak, jak to dané řešení vyžaduje.

V racku můžou být také různé druhy PDU od pasivního rozbočovače až po dálkově řízené řešení.

Podobně má každá organizace jiné nároky na bezpečnost, což vyžaduje modularitu i po přístupovém systému. Ve výchozím stavu tu máme nainstalované u každých dveří čtečky na čip. Pokud to ale bude potřeba, můžeme je snadno vyměnit za snímač otisku prstů nebo třeba krevního řečiště,

popisuje různé možnosti Václav Nesvadba.

Do uliček je možné také namontovat různě velké skříně, opět podle nasazené technologie. Ulička je postavená tak, aby se do ní vešlo šest 80centimetrových racků nebo osm 60centimetrových.

Aby mohli zákazníci hardware pohodlně navážet do sálu, jsou tu boční dveře vedoucí na parkoviště. Servery se nemusí složitě přenášet chodbami, existuje jednodušší cesta.

Bezpečnost a dohled

Informace z teploměrů, čidel i kamer se scházejí v horním patře v dohledovém centru, kde sedí dva operátoři sledující dvanáct velkých displejů se všemi potřebnými informacemi. Jsou tu dva kolegové, takže i tady jsme redundantní,

směje se Nesvadba.

Je tu vidět výstup z kamerového systému, sem přichází hlášení různých problémů z monitoringu a případně požadavky zákazníků. Stačí, aby někde pokleslo napětí nebo někdo nechal otevřené dveře do racku a okamžitě o tom víme a můžeme to začít řešit.

Tady naše prohlídka nového datacentra otevřeného k 25. narozeninám společnosti Faster končí. Máte tip na další návštěvu? Nebo nás chcete pozvat? Napište nám do redakce.

Můžete ještě nahlédnout na galerii z naší první návštěvy původního sálu: